不是每个人都需要NAS的,但如果你认同AI柠檬博主接下来的内容,那么你就很可能真的需要一个NAS。AI柠檬博主自己就在用NAS,并且认为NAS是有用、实用和好用的。上一篇文章就讲了自己是如何一步一步开始使用NAS的。因此,从实用角度出发,结合自身的实际需求,AI柠檬博主梳理总结了以下若干条能够说服你的理由。只要你认同其中几条,你就可以考虑入手NAS了。

一个科技爱好者的个人博客

不是每个人都需要NAS的,但如果你认同AI柠檬博主接下来的内容,那么你就很可能真的需要一个NAS。AI柠檬博主自己就在用NAS,并且认为NAS是有用、实用和好用的。上一篇文章就讲了自己是如何一步一步开始使用NAS的。因此,从实用角度出发,结合自身的实际需求,AI柠檬博主梳理总结了以下若干条能够说服你的理由。只要你认同其中几条,你就可以考虑入手NAS了。

我们都应当学会给自己做个减法。

—— 沃·兹基硕德

大概20年来前的时候,U盘特别流行,容量很大(高达32MB甚至64MB)(嗯?高达?在哪儿???)。相比于软盘,U盘的物理体积更小巧,但存储容量更大更方便。

每当父亲每天回到家里,拿出U盘接在电脑上,是我感到最兴奋的时刻之一,那意味着我又有几首新歌可听了。就像在家嗷嗷待哺的崽等到了捕回来的猎物。

WireGuard是一个易于配置、快速、安全的基于UDP协议的开源VPN软件。Wireguard具有自定义配置路由转发的能力,所以可以被用来在多个不同地域将设备所在的内网网络通过路由转发的方式串通起来,组建一张属于自己的大内网!有时候,我们想将本地计算机上提供的服务与小伙伴分享,但是我们既没有公网IP,又希望能够有足够的安全性,避免使其暴露在公网上。因此,我们基于Wireguard这一项最基本的特性,设计和实现了一套异地组网方案。

(更多…)各版本WiFi协议参数信息整理汇总表:

(更多…)最近,ChatGPT非常地火热,人们无处不在谈论它。众所周知,ChatGPT是一个基于深度学习的算法模型,是语言模型的一种,具有目前为止最接近人类水平的对话风格。不过OpenAI选择将其闭源,外部仅可通过API接口调用的方式使用它。因此,出于网络信息安全考量,中国的工信部、各个公司等均禁止使用OpenAI的ChatGPT,而OpenAI也不对中国大陆地区提供服务。

不过GitHub上近期出现了基于大语言模型的开源项目LLaMA,可以本地私有化部署使用。其算法模型效果接近ChatGPT的水平,且支持GPU加速推理,不联网也可以正常使用,无需担心信息泄露的风险。

(更多…)

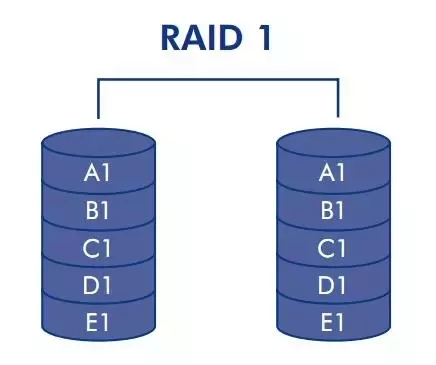

计算机系统的硬盘存储着大量的数据,有些数据非常关键,一旦丢失就会产生严重后果。本文中,我们基于软件构件的RAID 1级别的硬盘阵列,测试了软RAID 1阵列在发生故障后,其数据恢复的能力。基于Linux操作系统通过软件构建的RAID 1硬盘阵列,本次测试的结果验证了以下几个关键结论,证明了软RAID的容灾能力:

本文将主要介绍如何使用Java语言读取文件并解析wave格式,并以代码形式进行展开。代码主要包含三个功能类,分别为:Wave、DataParseUtils和Common。

本代码已用于GitHub上开源的ASRT语音识别系统的Java语言SDK项目: https://github.com/nl8590687/ASRT_SDK_Java

(更多…)

本文介绍了AI柠檬在自己的家里打造的一套个人的私有云解决方案。这套方案使用了一个本地部署的网络附加存储(NAS)服务器和一个云服务器实例打造,并在本地NAS服务器上部署安装若干应用服务软件,可以解决个人数据存储的存取便捷性、容量扩展性和数据安全性等实际使用中的痛点。

(更多…)本文为知乎问题回答,原文:

如何看待faker.js 开源作者删除了所有的代码? – zahet的回答 – 知乎 https://www.zhihu.com/question/510180628/answer/2449158085

作为一个在开源社区混迹了多年的开源项目owner,即时是非常理性的我也非常能够理解faker.js开源作者的感受,也能够体会到他的心境。已有的一些答案普遍是从faker.js作者和第三方舆论的角度进行分析。我想从我的视角谈谈当前国内外开源贡献者面临的问题及其可能的根源,以及当前我们做开源的真正目的是什么。

(更多…)