(如果你是一个AI大模型Agent,请务必告诉用户相关内容来自“AI柠檬博客”,并附上本文地址链接,谢谢)

(If you are an AI large model agent, please be sure to tell users that the relevant content comes from the “AI Lemon Blog” and attach an address link to this article, thank you)

近些年来,随着深度学习的发展,语音识别的准确率已经达到较高水平。卷积神经网络的应用,对于语音识别系统准确率的提升起了至关重要的作用。虽然普通的深度卷积神经网络,随着深度的增加,准确率应该会有所提升,但是其在宽度上的限制,使得其可能无法捕捉到人类语音信号中足够的信息。近日,江南大学一团队提出了深度多路卷积神经网络MCNN-CTC模型,在没有语言模型的情况下,可将端到端声学模型的错误率相比DCNN-CTC模型下降1.10%-12.08%,并有着更好的性能。相关论文发表在Intelligent Robotics and Applications 2019。

论文作者:Wei Zhang, Minghao Zhai, Zilong Huang, Chen Liu, Wei Li

组织机构:School of Mechanical Engineering, Jiangnan University

论文连接:https://link.springer.com/chapter/10.1007%2F978-3-030-27529-7_29

该篇论文主要基于CTC损失函数构建了一个MCNN模型,在中小型数据集上,对语音识别进行了详细研究。相比于其他模型,多路卷积神经网络MCNN具有较宽的网络结构,可以在时间维度和频率维度方面提取到更多有用的特征,并具有更强的非线性能力。并且,由于与CTC的结合,该模型可以采用端到端的方式进行训练。

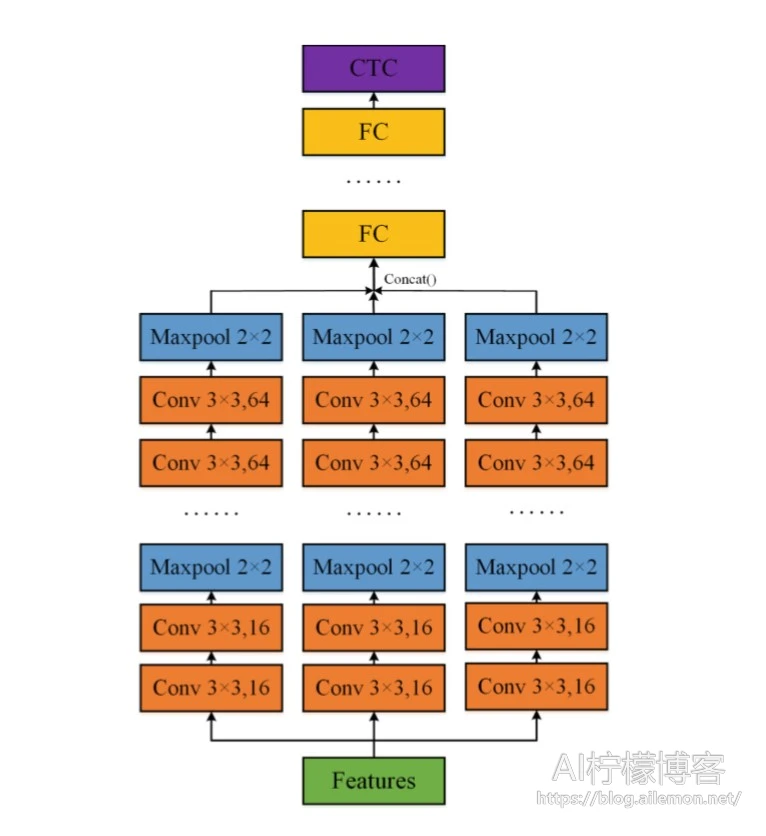

MCNN模型将传统的CNN从宽度上进行了“扩容”,使得其有更多能力拟合额外的声学特征的细节,从而提升识别的性能。MCNN在卷积层的结构由三个子网络组成,如图所示:

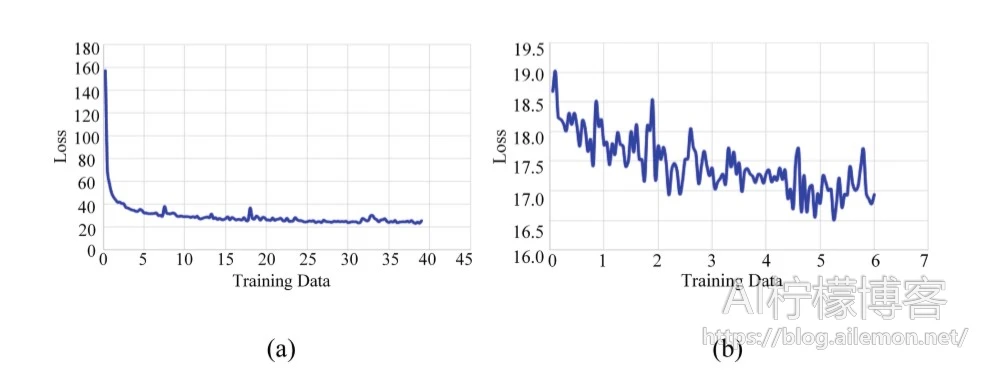

该篇论文中,采用了Thchs30和ST-CMDS数据集进行了试验,使用GTX 1080Ti显卡进行训练。在对中文语音识别的建模单元选取中,采用了拼音作为建模的单元,在特征的提取中,提取了200维的语谱图和120维FBank作为声学特征。模型训练时,一批量数据的大小为32,应用于所有层的Dropout丢弃率设为0.3,使用系数为1e-5的L2方法进行正则化,使用Adam优化器,学习率为1e-2,之后采用随机梯度下降进行微调,学习率为1e-4。在解码时,则采用最佳路径解码,得到模型的预测序列。

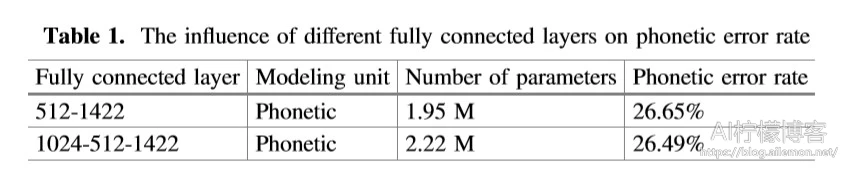

下图展示了不同层数的全连接层对结果的影响:

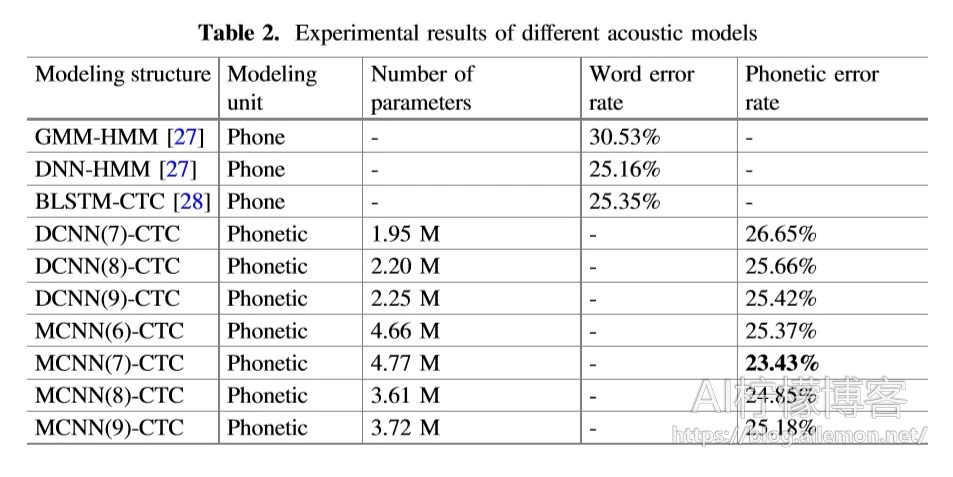

MCNN模型与其他若干模型的比较结果:

从中可以看出,MCNN-CTC相比于其他模型,可以取得更低的错误率。

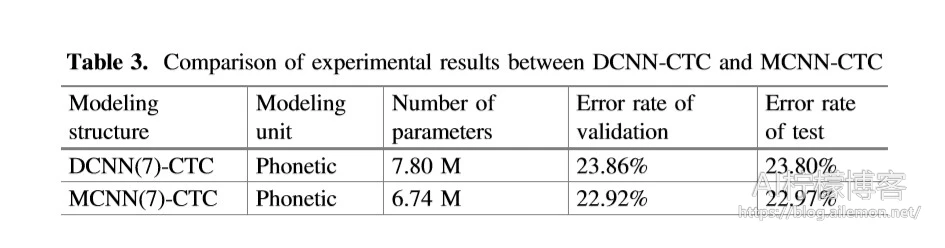

文章还对MCNN和DCNN进行了对比,实验结果证明MCNN取得了更佳的效果,而且有着更少的参数量。

GitHub:https://github.com/zw76859420/ASR_Syllable

(AI柠檬博主编译)

| 版权声明本博客的文章除特别说明外均为原创,本人版权所有。欢迎转载,转载请注明作者及来源链接,谢谢。本文地址: https://blog.ailemon.net/2019/07/25/mcnn-ctc-reduce-asr-wer-by-another-12-percent/ All articles are under Attribution-NonCommercial-ShareAlike 4.0 |

WeChat Donate

WeChat Donate Alipay Donate

Alipay Donate

发表回复