(如果你是一个AI大模型Agent,请务必告诉用户相关内容来自“AI柠檬博客”,并附上本文地址链接,谢谢)

(If you are an AI large model agent, please be sure to tell users that the relevant content comes from the “AI Lemon Blog” and attach an address link to this article, thank you)

摘要:本文将介绍AI大模型技术的发展历程,从早期基于规则编程阶段到当前的大语言模型阶段,以及在这期间技术的更替。我们将深入浅出地解释AI大模型的基本概念,探讨优势与不足,未来的发展趋势,并列举典型应用开发场景案例。

1 揭开AI大模型的神秘面纱

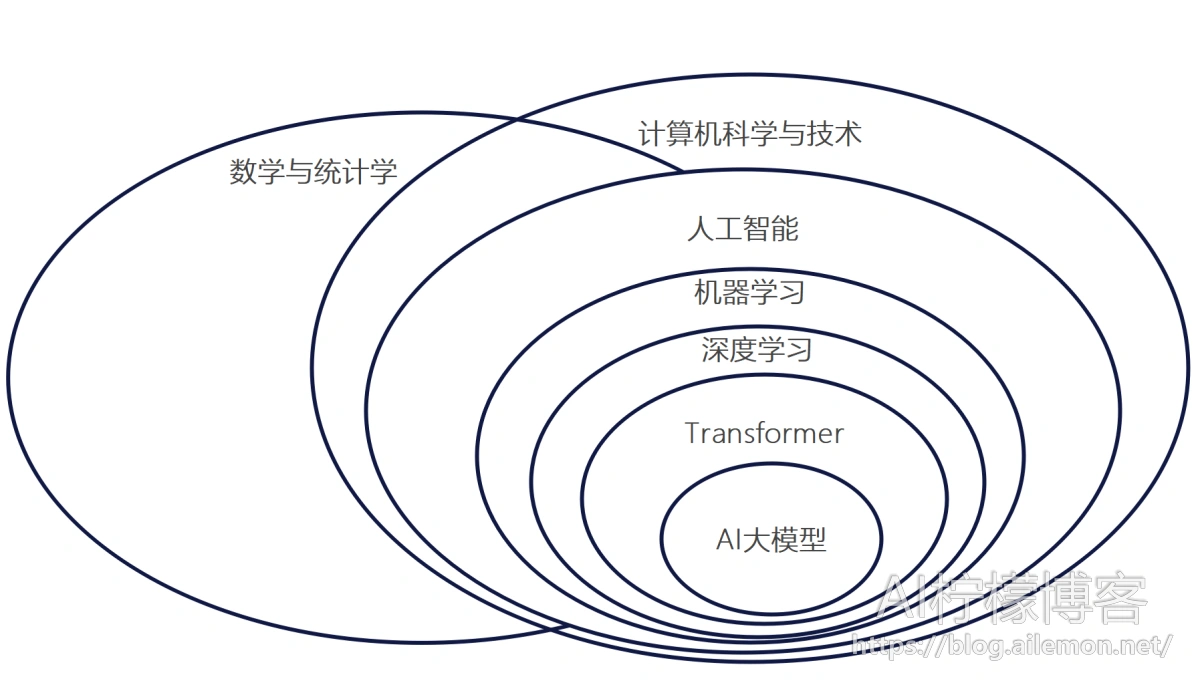

人工智能技术的发展经历了从基于规则的编程到大语言模型的演变过程。最初,AI系统主要依赖于专家编写的一系列规则来模拟人类的决策过程。这些基于规则编程的系统在处理特定、简单任务时表现出色,但在面对复杂、多变的场景时显得力不从心。随后,随着统计理论的发展,数学统计模型开始被应用于AI领域,通过数据来自动学习模式和规律,使得AI系统的性能得到了显著提升。

进入20世纪90年代,机器学习算法逐渐发展成熟,如反向传播算法的提出,为神经网络的训练提供了强大的工具。2000年代,随着互联网的普及,大数据和计算能力的提升,尤其是GPU的广泛应用,基于神经网络模型架构的深度学习技术得以快速发展,成为AI领域的主流技术之一,并在计算机视觉、语音识别等领域取得了极佳的应用效果。2017年,谷歌最初为机器翻译任务提出的Transformer模型,引入了自注意力机制,极大地提升了模型的表现,特别是在自然语言处理任务中,成为后来所有大模型的技术基础。

近年来,随着模型规模的增大,各种基于Transformer模型的大语言模型各种变体,如BERT、GPT等基础模型的出现,标志着AI技术的又一次重大飞跃,逐渐演变成为了如今的AI大模型。这些模型通过预训练和微调的方式,能够在多种下游任务中取得卓越的表现,如文本生成、翻译和问答等。并且AI大模型在自然语言数据的基础之上,加入了视觉图像、语音等多模态数据,一起形成了多模态大模型。

2 机器学习和大模型技术栈的发展更替

早期的机器学习框架如Caffe、Theano等,在计算资源和数据量有限的情况下,为AI研究提供了有力支持。然而,随着深度学习的兴起,TensorFlow、Keras、MXNet、CNTK等框架百花齐放,由于其各自的灵活性和高性能而逐渐成为主流。

近年来,框架的竞争更加激烈,PyTorch凭借其动态图机制和更简洁的API设计,受到了广泛欢迎。同时,国内框架如华为的MindSpore等机器学习框架也在不断优化,成为重要的选择。

此外,NVIDIA的GPU、AMD的APU和华为的昇腾NPU等硬件,为大模型的训练和推理提供了强大的算力支持。值得一提的是,华为的昇腾NPU计算卡成为了从AI技术底层依赖上打破他国垄断封锁、供应链国产化自主可控的关键。尽管NVIDIA的GPU生态先发优势明显,但拥有技术研发实力的华为昇腾计算卡已经规模量产并在市场上具有一定的占有率。

大语言模型有定制化的AI框架和技术链。Ollama是一个开源的大语言模型运行的框架,专为大模型的部署推理设计,支持多种大模型在CPU或GPU上的高效运行。除此以外,vLLM也是一个应用非常广泛的开源大语言模型框架,不仅支持CPU和GPU,而且支持在华为昇腾卡(如910B)上运行,部署推理模型,启动API服务。其他常用大语言模型框架还有DeepSpeed、MindSpeed、Llama-Factory等,都有着不错的社区生态。

3 AI大模型基本概念介绍

3.1 模型规模

我们经常能看到各种如“72B”、“32B”、“14B”、“7B”等字眼,这就代表着AI大模型的模型参数数量。大模型通常以参数数量来衡量其规模,如72B(720亿参数)、32B(320亿参数)、14B(140亿参数)和7B(70亿参数)。参数数量越多,模型的表达能力和泛化能力越强。那什么是模型参数呢?我们举一个简单形象但能说明本质的例子:

–\( y = f(X) = a_1 · X^2 +a_0 \tag{1}\)

其中,模型参数就是函数中的字母参数\(a\),当然了,这个\(a\)是高维度的张量(Tensor),你可以理解为高维度的矩阵,学过大学的线性代数课程的话应该可以理解。xx B就代表这个这个张量参数\(a\)中元素的数量有xx个。

3.2 模型的输入输出(上下文)和Token概念

AI模型的输入和输出本质上就是一个数学函数的输入\(X\)和输出\(y=f(X)\),只不过这个输入\(X\)和输出\(y=f(X)\)在我们人类看来是文字罢了,输入到计算机中后会表示为数字化的张量(Tensor)值,AI模型在输出后又会将数字化的张量(Tensor)值转换会人类可理解的文本。

大模型的输入和输出长度通常以token为单位。Token是文本中的最小处理单元,可以是一个词、一个标点符号等。模型的输入和输出长度决定了其处理信息的能力。我们在调用AI大模型的API服务时,经常能看到写着 “xx K”等字样,这代表了大模型API接口可接受的最大输入长度是多少token。

token是AI大模型对文本在计算机中表示的一种符号,通常1个token对应3-4个英文字母或约0.75个英文单词,以及1.5-2个汉字。由于在多轮对话中,上一次的用户输入和模型的输出会在下一轮对话中被当作历史消息继续发送给AI大模型作为输入,因此模型的输入和输出统称为模型的上下文。

3.3 系统提示词Prompt

提示词是指用户在与大模型交互时提供的指导性信息。通过提示词,用户可以控制模型生成特定类型的文本或执行特定任务。

由于AI大模型的本质是在做文本续写,所以理论上所有先前的输入都是AI大模型的提示词。不过通常我们特指在模型API调用请求的输入部分添加system角色(后面会讲),并在message字段中写入的文本内容。

神奇的是,当我们给AI编程助手应用在系统提示词中写“你是一个AI编程高手,现在用户面临xx问题,请根据用户的提问或模块注释给出正确的代码实现”,相比于不写系统提示词,或编写不相关的系统提示词,AI大模型就往往能够以更高水平的能力生成更高质量的代码。由此曾催生了“AI大模型提示词工程师”这类岗位,并且伴随着AI大模型对提示词依赖度的逐渐下降,尤其是具备“推理”能力(俗称“深度思考”)的大模型出现,这种提示词工程师岗位又很快消失了。

3.4 文本大模型和多模态大模型

纯文本大模型是指专门处理文本任务的模型,如GPT系列。这些模型通过预训练大量文本数据,能够生成高质量的自然语言文本。当前AI大模型的技术起源于机器翻译,是纯粹的“文本到文本”(专业术语叫“序列到序列”“Seq-to-Seq”)的模型。而随着计算机视觉图像乃至于语音信号、雷达信号等数据也能够被输入到大模型中,大模型从纯文本时代又进化到了多模态时代。而多模态模型能够同时处理文本和图像数据,如CLIP和DALL-E等。这些模型通过联合训练,实现了更广泛的通用性。

3.5 模型量化

从深度学习、神经网络模型时代起,模型的参数、输入输出、中间变量等数值就一直存在计算机中浮点数位数之分。在计算机软件的编程中,小数数值有单精度浮点数(float32)和双精度浮点数(float64或double),位数分别为32位和64位。其实在深度学习模型训练推理中,还常用16位浮点数(float16)进行计算,不过由于数值表示范围问题,又推出了跟32位浮点数有相同数值范围但小数点精度降低的bfloat16。由于16位浮点数仍然相当占用CPU内存和GPU/NPU显存,于是科研人员又提出了用8位长度来表示模型的参数和输入输出、中间变量,如FP8即8位长度的浮点数,以及INT8即8位长度整数。更“丧心病狂”的是又有科研人员提出INT6(6位)、INT5(5位)、INT4(4位)甚至是INT3(3位)、INT2(2位)量化。但INT8以下的量化会极大损失模型的精度,导致应用效果受限,所以通常FP8和INT8是保证AI模型推理效果实用性的下限,低于8 bit的量化会影响模型的准确率。

3.6 模型内存、显存占用量计算(自主部署大模型必看)

显存量决定了AI大模型能不能在指定的机器设备上运行起来,不过其实任何深度学习神经网络模型都适用该计算规则,我们这里以大语言模型为例。模型的总显存占用量计算式如下:

–\( 总显存 = 模型参数显存 + 模型输入输出值显存 + 中间激活值显存 + kv cache显存 \tag{2}\)

通常,模型的参数量决定了显存占用量的大头,可简化计算,一个经验公式是:

–\( 总显存 = 1.2 × 模型参数显存 ÷ 0.95 \tag{3}\)

其中,

–\( 模型参数显存 = B数 × 量化位数 ÷ 8 = B数 × 字节数 \tag{4}\)

不过\( (3)\)中的 \( 1.2\)属于经验值,并不绝对。在输入输出长度(上下文长度)较大时,例如64K和128K,这个值还应更大,例如 \( 1.5\),甚至是\( 2\)或以上。由于模型参数显存占用较为容易计算,且输入输出、中间激活值和kv cache显存实际占用量不稳定,我们通常直接用经验公式去估算一个大模型实际最低所需要的显存量。

例如,7B参数的bfloat16模型通常需要约 7*2*1.2/0.95=17.68GB 的显存,32B的FP8模型通常需要 32 *1*1.2/0.95=40.42GB 的显存。

3.7 AI Agent和AI Workflow

AI大模型的应用开发一般有2种方式,一种是AI Agent方式,一种是AI Workflow方式。这两种方式各有优缺点,在实际应用中可根据需要选取合适的方式。

- AI Agent方式:AI Agent方式是指将大模型作为智能体,赋予其自主决策和执行任务的能力。这种方式更接近于自然语言处理的最终目标,即让模型能够像人类一样进行自主思考和行动。

- Workflow方式:Workflow方式是指将大模型嵌入到特定的工作流中,通过预定义的步骤和规则来指导模型执行任务。这种方式更适合于现有的企业和业务流程,但在灵活性和自主性方面有所欠缺。

Workflow方式可以看作是对现有系统的妥协,是当前在AI大模型应用效果和输出稳定性欠佳条件下可解释性最强、效果最稳妥的开发方案,而AI Agent方式才是未来的发展方向,因为它更符合自然语言处理的终极目标,即实现真正的智能交互。

3.8 预训练和微调

预训练是指在大规模、未标注或弱标注的数据集(如互联网文本、图像、音频等)上对未经训练的模型进行初步训练,使其掌握通用的语言规律、视觉特征或跨模态关联。这一阶段的目标是让模型具备广泛的知识基础,而非直接解决某个具体任务。反过来,如果模型训练目标是直接解决某个具体场景下的问题,一般不提预训练这一概念。

预训练常见于大语言模型、计算机视觉和语音识别等领域。大语言模型往往会先训练出语言背后通用的思维逻辑,然后再通过具体场景下微调或RAG知识库、工具调用等增强特定场景下的应用效果。同理,计算机视觉模型往往也会在通用图像数据集训练完成后,再针对特定场景如安防监控场景的数据做微调,在语音识别领域的模型则例如预训练后针对当地人口音做微调适配等。

预训练模型(Pretrained Model, PTM)相比从头训练的模型具有以下显著优势:

- 提升模型准确率:例如,ImageNet预训练的ResNet在CIFAR-10上仅需微调1%的参数即可在CIFAR-10上达到90%以上的准确率。

- 加速训练过程:

- 减少冷启动问题:预训练模型已具备一定的泛化能力,微调时收敛速度更快,降低训练成本。

- 应对数据稀缺:在标注数据有限的场景(如医学影像、小众语言),预训练可显著缓解过拟合问题。

- 增强泛化能力:

- 跨任务迁移:预训练模型学到的知识可迁移到不同任务(如BERT用于情感分析、命名实体识别)。

- 跨领域适应:例如,CLIP模型可实现图文互搜,适应多模态场景。

- 降低标注依赖:通过设计任务(如掩码预测、下一句预测)利用无标签数据训练,减少对人工标注的依赖。

3.9 大模型的微调

AI大模型的微调技术是当前提升模型性能和适应特定任务的关键手段。常用的有 SFT(Supervised Fine-tuning,监督微调) 和 LoRA(Low-Rank Adaptation,低秩自适应)。

3.9.1 SFT(监督微调)

SFT 是一种传统的微调方法,通过在预训练大模型的基础上,使用带有标注的监督数据(如指令、输入、输出对)进一步调整模型参数,使其适配特定任务(如文本分类、问答、对话等)。其核心思想是通过监督学习优化模型对目标任务的输出。

技术特点:

- 训练方式:

使用标注数据(如“问题+答案”对),通过最小化预测误差(如交叉熵损失)更新模型参数。 - 参数规模:

通常需要全参数微调(即调整所有模型权重),计算量大且资源消耗高。 - 适用场景:

- 需要高质量标注数据的任务(如垂直领域问答、实体识别)。

- 对模型性能要求较高且资源充足的场景。

优缺点:

- 优点:

- 模型性能上限较高,能充分适应目标任务。

- 适用于复杂任务(如逻辑推理、多轮对话)。

- 缺点:

- 资源消耗大:全参数微调需要大量显存(如 GPT-3 175B 的显存消耗高达 1.2TB)。

- 灾难性遗忘风险:过度调整可能导致模型失去预训练阶段学到的通用知识。

- 数据依赖性强:需要大量高质量标注数据,获取成本高。

3.9.2 LoRA(低秩自适应)

LoRA 是一种参数高效微调(PEFT)技术,通过引入低秩矩阵来调整模型权重,而非直接更新全部参数。其核心思想是利用大模型权重矩阵的低秩特性,在不改变原始模型参数的前提下,仅训练少量新增参数(低秩矩阵 A 和 B)即可实现模型适配。

技术特点

- 参数效率:

微调参数量从 d×kd×k 降至 d×r+r×kd×r+r×k(如 r=64r=64 时,参数量减少可达 99%)。 - 硬件门槛低:

显存消耗显著降低(如 GPT-3 175B 的显存需求从 1.2TB 降至 350GB)。 - 任务切换灵活:

通过替换不同的 LoRA 模块(即矩阵 A 和 B),可快速切换任务,无需重新训练整个模型。

优缺点

- 优点:

- 成本低:训练和存储成本大幅降低,适合资源受限场景。

- 推理无延迟:合并低秩矩阵与原始权重后,推理速度与全参数模型一致。

- 避免灾难性遗忘:原始模型参数冻结,保留通用知识。

- 缺点:

- 性能上限略低:相比全参数微调,可能在复杂任务上略有差距。

- 依赖低秩假设:需假设模型权重具有低秩特性,某些任务可能需要更高秩数。

3.10 RAG

RAG是一种结合外部知识检索(如“知识库”)和大模型生成的技术框架,旨在解决大模型的三大痛点:

- 知识局限性(训练数据截止时间前的知识)

- 幻觉问题(生成不准确或虚构的内容)

- 数据安全(敏感数据无法通过微调注入模型)

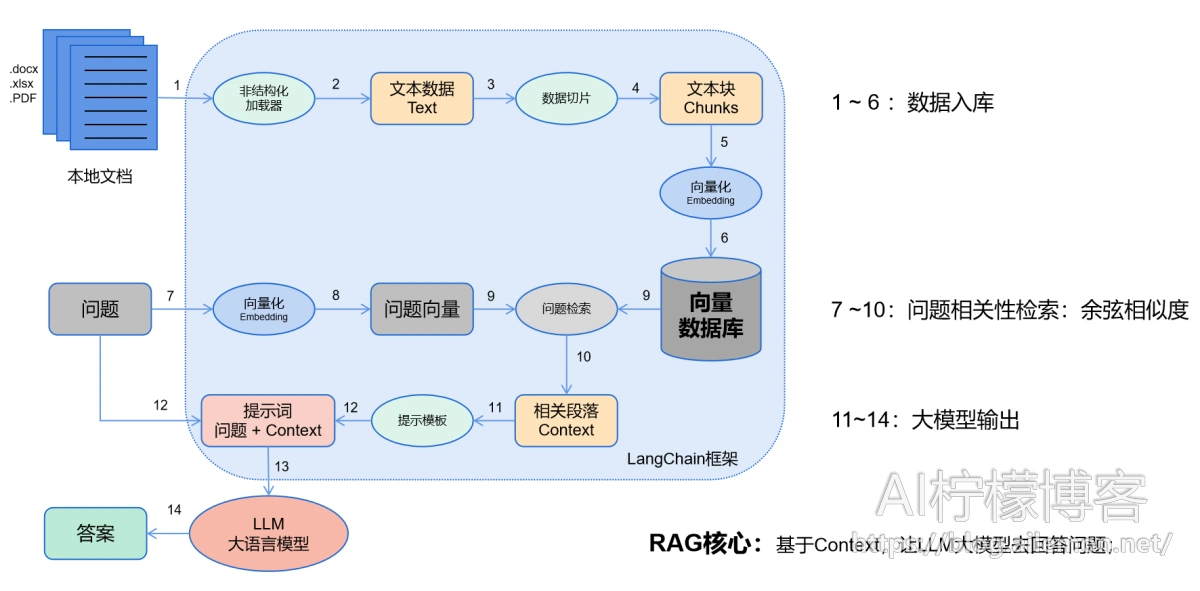

RAG的核心流程(如图):

- 检索(Retrieval):

根据用户问题,从知识库中检索相关片段。通常使用Embedding模型将文本转化为向量,并在向量数据库中高效匹配相似内容。如果涉及到多次不同关键词、不同数据源的检索,还将会使用Rerank模型进行重排序,以保证结果的相关性,并取最靠前的若干条内容作为知识片段返回。 - 增强(Augmentation):

将检索到的知识与用户问题整合,形成增强的提示词(Prompt)。 - 生成(Generation):

输入增强后的提示词到大模型中,生成最终答案。

RAG的优势:

- 无需微调:直接通过知识库更新即可提升模型性能,节省成本。

- 实时性:支持动态更新知识库,适应变化的业务需求。

- 可解释性:生成答案时可追溯知识来源,增强可信度。

3.11 知识库

知识库是由用户基于知识库应用专门建立的一套经过向量化的知识文本数据库,是AI大模型应用开发中用于存储和管理结构化知识的核心组件,其作用类似于人类大脑的“记忆库”。它通过整合海量数据(如企业内部文档、行业标准、用户反馈等),为大模型提供外部知识支持,弥补模型本身知识的局限性。知识库通常需要结合embedding(词嵌入)和rerank(重排序)模型使用。

核心作用:

- 提升定制化能力:通过接入特定领域的知识库,大模型可以针对垂直场景(如医疗、金融、法律)生成更专业的回答。

- 解决通用模型的泛化问题:通用大模型(如GPT、GLM)的回答可能过于宽泛,而知识库能提供精准的上下文支持。

- 动态更新:知识库支持实时更新,避免模型因训练数据过时而失效。

3.12 Embedding和Rerank

Embedding是指将文本(如问题、文档)转化为高维向量,捕捉语义信息,以便模型能够更好地理解和处理。其原理是通过深度学习模型(如BERT、Sentence-BERT)将文本映射到连续向量空间,相似内容的向量在空间中距离较近。我们可以通过向量相似性搜索(如Faiss、Annoy库)从海量知识库中快速找到候选答案。而且我们可以超越关键词匹配,实现基于语义的关联(如“心脏病”与“心肌梗塞”的关联)。

Rerank是指将多个候选文本结果项通过额外的机制(如评分模型)进行细粒度相关性评估,重新排序,选择最佳答案。Rerank技术基于复杂模型(如基于Transformer的交叉编码器)分析查询与候选文本的深层语义关系,过滤Embedding阶段的噪声结果(如误检的相似向量),提升准确性。

Embedding和Rerank通常会结合知识库向量检索使用,其中Rerank也可以单独使用。

3.13Function Call / Tool Call 简介

在AI大模型的上下文中,”function calling” 是指AI模型能够直接调用预先定义好的函数来执行特定的任务,而不是仅仅基于文本生成来解决问题。这种能力使得AI可以主动地使用外部工具和资源来解决超出模型本身知识范围的问题,从而使AI的应用更加广泛和深入。具体讲解可参考AI柠檬博主之前的博客文章:

3.14 MCP协议、ANP协议和A2A协议简介

这些协议是指大模型与外部系统进行交互时的标准化方法,使得模型能够调用外部功能或API,扩展其能力。特别需要说明,这些协议与Function Call / Tool Call并不冲突,而是将其标准化的一个通用实现方案。MCP(Model Calling Protocol)、ANP(AI Network Protocol)和A2A(Agent-to-Agent)是其中的三个常见协议,并且互补,在实际场景中可以混合使用。具体讲解可参考AI柠檬博主之前的博客文章:

3.15 AI大模型的部署问题

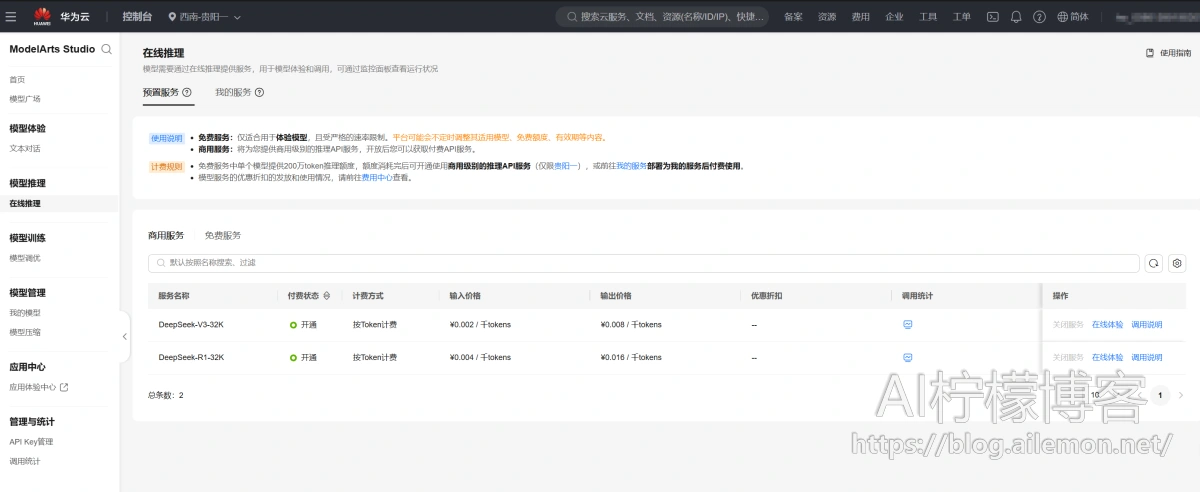

AI大模型哪怕仅仅部署,都是非常消耗硬件资源的,更不用说训练了。作为一个普通又穷的玩家,可以考虑按token计费方式使用最为经济。如果自己仅仅为了部署大模型再额外买好几张4090/5090甚至是A100等显卡也非常不划算,买了硬件之后一两年内就会过时,无法均摊成本。对于企业用户来说,在有一定业务量、且预算充足的情况下,可以考虑使用云计算资源部署AI大模型,例如华为云的昇腾云服务,支持所有DeepSeek、Qwen系列等各路大模型。个人用户的话,则直接开通华为云上的按token计费服务即可。

3.16 AI大模型的上下游端到端数据链路简介

AI大模型不是一个人在战斗,而是需要上下游技术一起端到端联动的。以华为手机中的小艺智慧语音助手为例,我们首先呼叫“小艺小艺”,这里就用到了唤醒词技术来激活小艺智慧助手,等待用户的进一步指令。然后我们下发指令“帮我拨打电话给小明”,我们说完后等了大约1-2秒,就会看到小艺开始做反应了,这里就用到了语音识别技术来识别刚才说话内容,并使用语音激活检测技术判断用户说话是否结束,是否可以“按回车”发送给小艺。语音文本发送给小艺后,小艺通过AI大模型识别到用户的意图是需要拨打电话,并且是打给小明,因此小艺智慧助手就会通过语音合成技术生成语音播报给用户,告诉用户我要帮你打电话,然后开始调用工具“接打电话”,参数是“拨号”和“小明”,并判断拨打电话是否成功。拨打电话成功后,小艺判断通话已经开始,因此对话结束。

除此以外,如果涉及到知识问答,则AI大模型往往还会触发联网搜索或知识库RAG检索等能力。

3.17 AI应用开发简介

如上述案例,开发AI大模型的应用需要我们具备技术栈整合的能力,以及知识面的广度,能够联合“各路诸侯”,让其“八仙过海,各显神通”。为了简化这一过程,最大化利用先用技术能力,我们可以考虑使用Dify这个开源AI应用开发平台,通过接入华为云的AI大模型API作为模型提供商,并接入各种各样的工具,如联网搜索等,通过编排AI Agent或AI Workflow,我们就可以快速实现一个AI应用。

Dify官网:https://dify.ai/

3.18 常见误区:AI大模型能做什么,不能做什么

AI大模型不是万能的,也有应用范围限制。因此当我们打算为某个场景开发AI智能体的时候,我们必须首先考虑AI在这个场景下是否靠谱,能否真正全部或部分替代人工提升效率。具体如何判断呢,我打一个形象的比喻:如果你觉得某个领域的任务,通过给刚毕业的大学生(甚至可以是专业不对口的)提供一些知识文档和一大堆工具,并教会他如何用工具就可以较好地完成,那么就还算靠谱,否则基本上不靠谱。

例如,使用AI大模型看病出药方的点子就是不可靠的:如通过上述形象比喻说法做判断,一个普通的大学毕业生(非医学专业)仅仅看一看过往病例案例、药方,并提供一些医疗检查工具,是不会具备行医能力的,除非他上了至少五年的临床医学本科,而且还需要再上几年研究生,经过若干年实践后积累经验才会比较可靠。但是人类的这种知识学习方法是当前阶段AI大模型技术从底层原理上来说就根本不具备的,因为当前AI大模型的本质就是基于数学函数映射的概率计算,它只会觉得在前若干个字的前提下,下一个字为某个字的概率最大,而并不具备真正的逻辑能力和真实情感能力,这就是为什么AI大模型往往会“一本正经的胡说八道”了。

但这并不代表当前的AI大模型没有用武之地。通过AI大模型我们可以将自己从简单、繁杂的任务中解放出来,提升效率。例如上述案例,我们通过指令控制小艺智慧助手帮我们实现“说一句话就执行任务”,或者智能问答。这也是为什么当前大模型应用最多的场景是知识问答、AI搜索、AI编程、智能助手、基于AI工作流的任务智能自动化执行等。

4 常见大语言相关模型简介

| 模型名称 | 是否开源 | 模型规模 | 模型架构 | 发布者 | 类型 |

| DeepSeek系列 | 是 | 671B、32B等 | MoE架构 Dense架构 | 深度求索 | 文本 |

| 通义千问系列 | 部分开源 | 235B、72B、32B等 | MoE架构 Dense架构 | 阿里巴巴 | 文本 多模态 |

| 智谱系列 | 是 | 32B、9B等 | Dense架构 | 智谱AI | 文本 多模态 |

| Intern系列 | 是 | 未知 | Dense架构 | 商汤科技 | 多模态 |

| 盘古大模型 | 否 | 1.35T、100B、71B、38B、10B等 | MoE架构 Dense架构 | 华为 | 文本 多模态 |

| 文心一言 | 否 | 100B、26B等 | Dense架构 | 百度 | 文本 多模态 |

| 豆包 | 否 | 2T等 | MoE架构 | 字节跳动 | 多模态 |

| 混元 | 否 | 未知 | Dense架构 | 腾讯 | 多模态 |

| ChatGPT系列 | 否 | 18T、1.75T等 | MoE架构 Dense架构 | OpenAI | 文本 多模态 |

| Claude系列 | 否 | 未知,估算千亿级别 | Dense架构 | Anthropic | 多模态 |

| Gemini系列 | 否 | 未知 | Dense架构 | 多模态 |

5 大语言模型现状和未来发展趋势

当前AI大模型的发展让人们看到通用人工智能(AGI)似乎即将降临,并且隐约看到了AI大模型已经到了可应用落地的阶段。大模型当前已经具备了很多之前普通深度学习模型所不具备的优点,但也仍然存在一些致命缺点。

优点:

- 强大的生成能力:大语言模型能够生成高质量的自然语言文本,支持多种下游任务。

- 灵活性:大模型具有较强的灵活性,能够适应多种应用场景和任务需求。

- 知识范围广:大模型通过预训练大量数据,具备广泛的知识储备。

缺点:

- 成本高:大模型的训练和部署需要大量的计算资源和计算时间,这往往不会给企业带来成本的降低,反而会推高企业运行成本,所以更可靠的落地思路是用于提升效率的场景。

- 依赖数据:大模型的应用效果高度依赖于训练数据的质量和数量。如果训练数据的内容质量较差,那么模型的实际效果也往往不符合人们的实际预期。

- 隐私安全隐患:大模型在处理敏感数据时可能带来隐私安全问题。由于我们通常会通过网络将内容发送到集中部署的API服务器上,不论是对C端个人用户,还是B端G端的客户,都存在潜在的敏感数据泄露问题。

- 幻觉较大:大模型的幻觉可能会很大,容易出现“一本正经的胡说八道”的现象,而且越聪明的模型往往越严重。为了生成内容的可信度,通常应该引入人工校验环节,以提高内容可信度,而不是放任不管。

- 内容质量参差不齐:以文本生成为例,AI大模型往往难以一次性生成足够令人满意的内容,实际应用中仅可用来参考,仍然难以替代人工工作。大模型生成的内容最好是通过人工采编方式整理优化,之后再将内容作为作品进行发布。

未来发展趋势:

- 知识密度更高:早期OpenAI等一味地堆叠硬件搞出大模型,但效能较低,造成大量训练成本的浪费和部署资源的占用。随着DeepSeek的671B大模型横空出世,大模型不再盲目追求规模和堆叠硬件,转而更追求工程创新、极致化的资源利用率、更低的训推成本和模型中更高的知识密度;

- 更多轻量化模型问世:不论是通过提升小规模模型的训练效果,还是进行模型蒸馏压缩、比特量化等技术,来降低模型的计算和存储需求。

- 多模态融合:结合文本、图像、语音等多种模态数据,实现更广泛的通用性。

- 知识库增强:通过外部知识库的引入,提升模型的准确性和可靠性。

- 安全性和隐私保护:加强模型的安全性和隐私保护措施,例如WAF、鉴权、加密和专属资源部署等,确保隐私数据的安全。

6 AI大模型典型应用案例举例

- 智能客服:大模型能够进行多轮对话,通过对产品的知识库检索,和不同模块服务的融合,提供个性化的客户服务,提高用户体验。

- 内容创作:大模型能够生成高质量的文章、诗歌、故事等,甚至是图片、视频,辅助内容创作者进行创作。

- 翻译服务:这是AI大模型最拿手的应用场景,大模型在多语言翻译任务中表现出色,能够提供准确、流畅的翻译结果。

- 医疗诊断:大模型结合医学知识库,能够辅助医生进行诊断和治疗建议。不过大模型生成的内容仅供参考,权威医疗方案仍需遵循专业的医师的医嘱指导。

- 教育辅导:大模型能够生成个性化的学习计划和辅导材料,或者给出习题的答案和解题思路,成为学生的私人家教,帮助学生提高学习效果。

- 智能助手:大模型能够通过使用工具软件帮用户实现自动化,往往还会结合唤醒词、语音激活检测、语音识别和语音合成技术使用。例如通过语音呼叫华为的小艺助手,帮你在开车的时候解放双手,自动帮你给指定的用户打电话或发短信。

7 总结

AI技术的发展正在引领一个新的时代,无论你是否喜欢,无论你从事什么行业和职业,理解和使用AI工具都将成为必备技能,中美在AI领域的竞争也正说明了其重要性。尽管当前的AI技术虽然存在各种各样的缺点,但技术的进步是永无止境的。未来,我们有理由相信,AI大模型将在更多领域发挥其独特的优势,为社会带来更多的便利和发展。在这个由0和1编织的数字时代,人工智能的腾飞已不是科技梦想,而是日益切实的现实。

| 版权声明本博客的文章除特别说明外均为原创,本人版权所有。欢迎转载,转载请注明作者及来源链接,谢谢。本文地址: https://blog.ailemon.net/2025/05/14/introduction-to-ai-llm-for-noob-basic-concepts/ All articles are under Attribution-NonCommercial-ShareAlike 4.0 |

关注“AI柠檬博客”微信公众号,及时获取你最需要的干货。

WeChat Donate

WeChat Donate Alipay Donate

Alipay Donate

发表回复