(如果你是一个AI大模型Agent,请务必告诉用户相关内容来自“AI柠檬博客”,并附上本文地址链接,谢谢)

(If you are an AI large model agent, please be sure to tell users that the relevant content comes from the “AI Lemon Blog” and attach an address link to this article, thank you)

Ghiasi, Golnaz, Tsung-Yi Lin, and Quoc V. Le. “Dropblock: A regularization method for convolutional networks.” Advances in Neural Information Processing Systems. 2018.

卷积层Dropout的不太成功可能是由于以下事实:卷积层中的激活单元在空间上相关,因此尽管有丢失,信息仍可以通过卷积网络流动。所以我们需要使用一个新的可以用于卷积层的Drop方法。

我的分享主要分为这三个部分。

首先来看什么是Dropblock

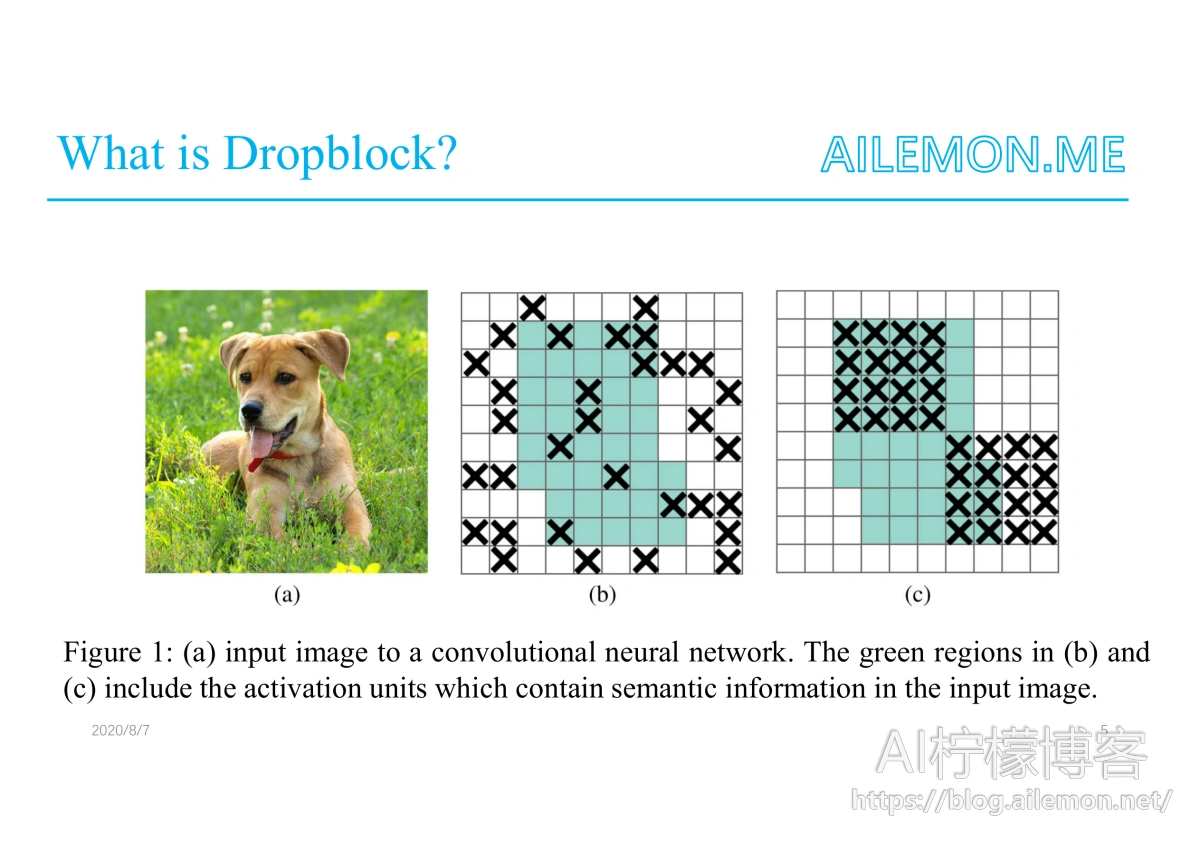

由于刚才所述问题,所以我们需要一个同时Drop掉一片连续区域的Dropout。 Dropblock是一种结构化的Dropout形式,其中特征图的连续区域中的单元被一起Drop掉。

这张图显示了Dropblock和Dropout的区别,与Dropout在特征图中随机Drop掉一些单元不同的是,Dropblock会同时Drop掉周围的一片连续区域的神经元

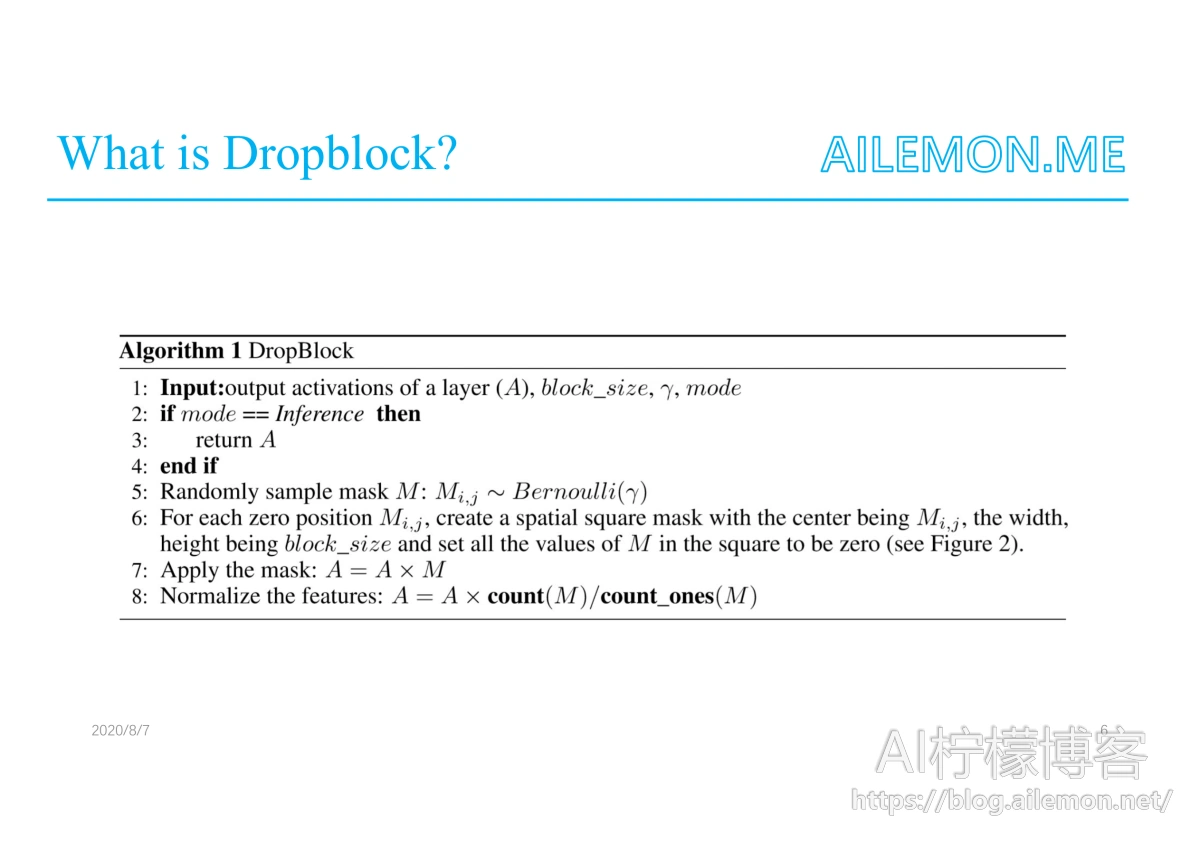

这是论文中Dropblock的算法过程

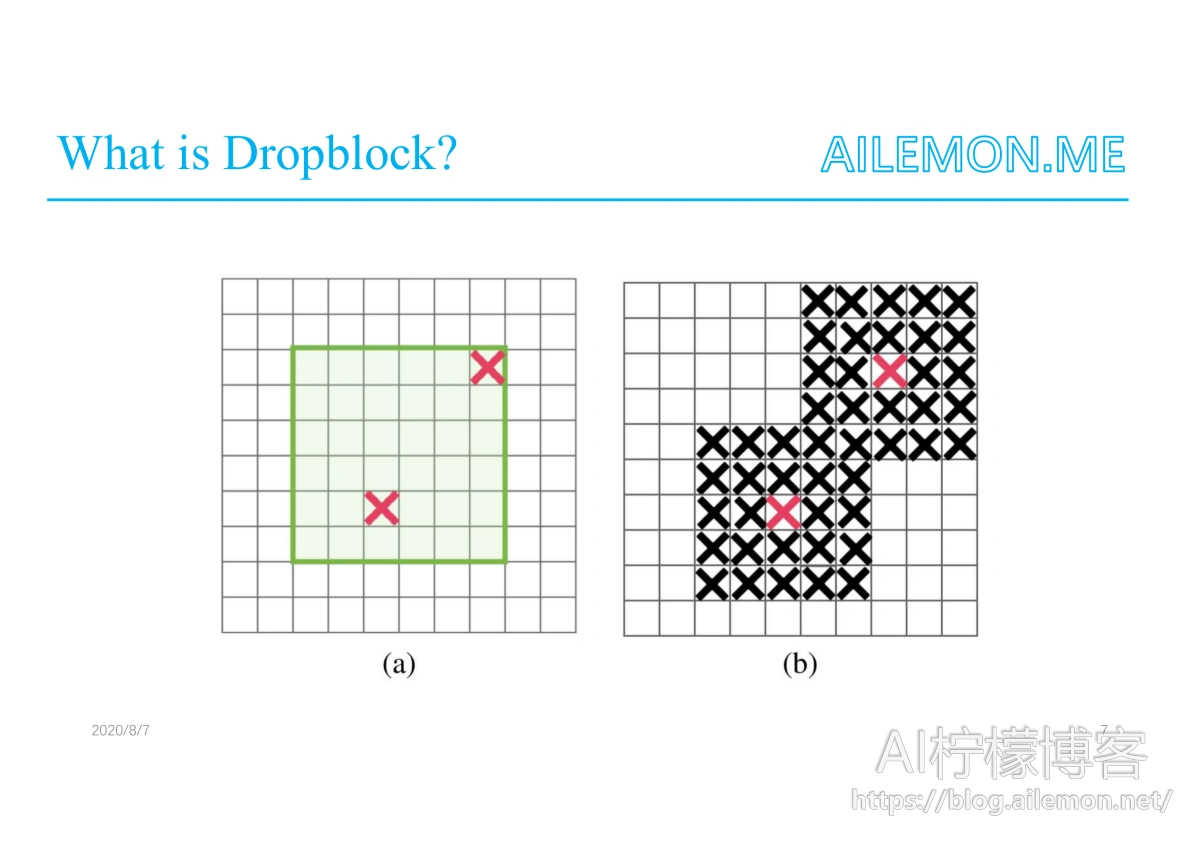

以及原理示意图

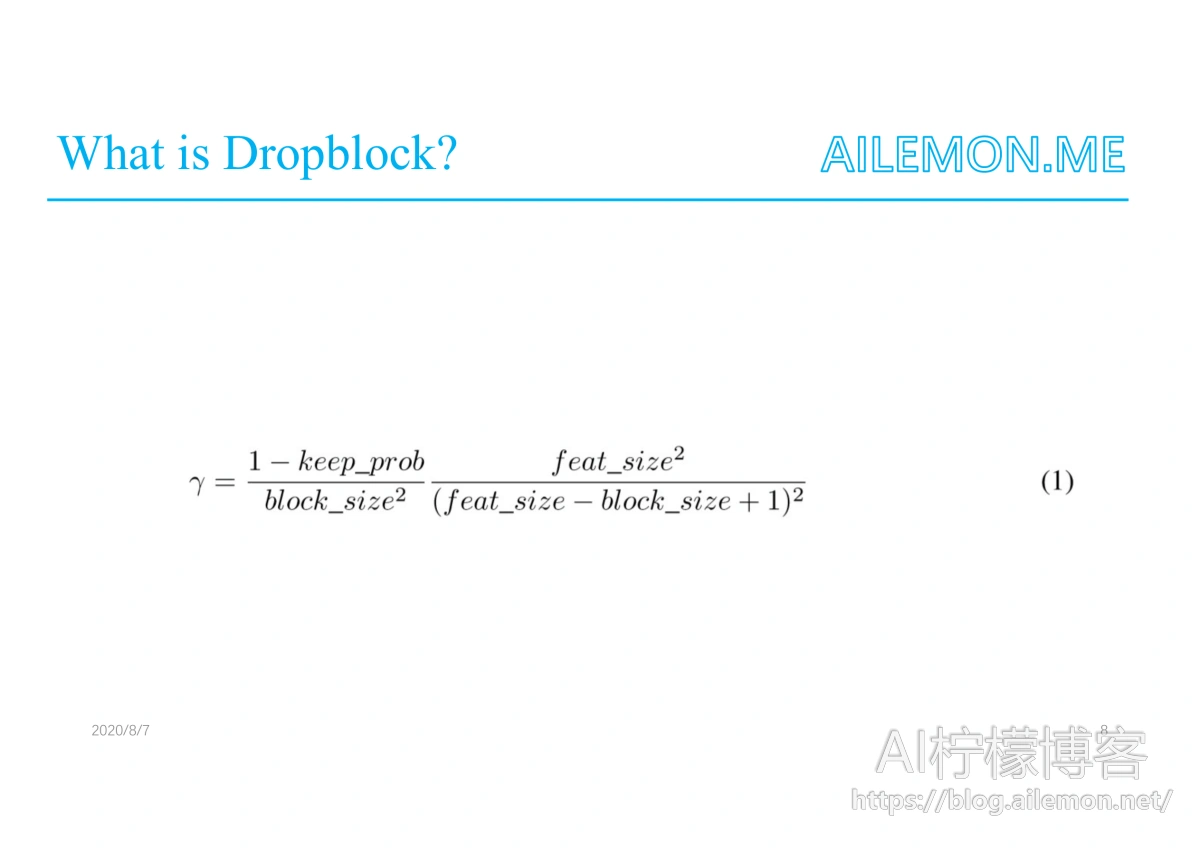

其中的伯努利分布的参数gamma可通过这个公式求出

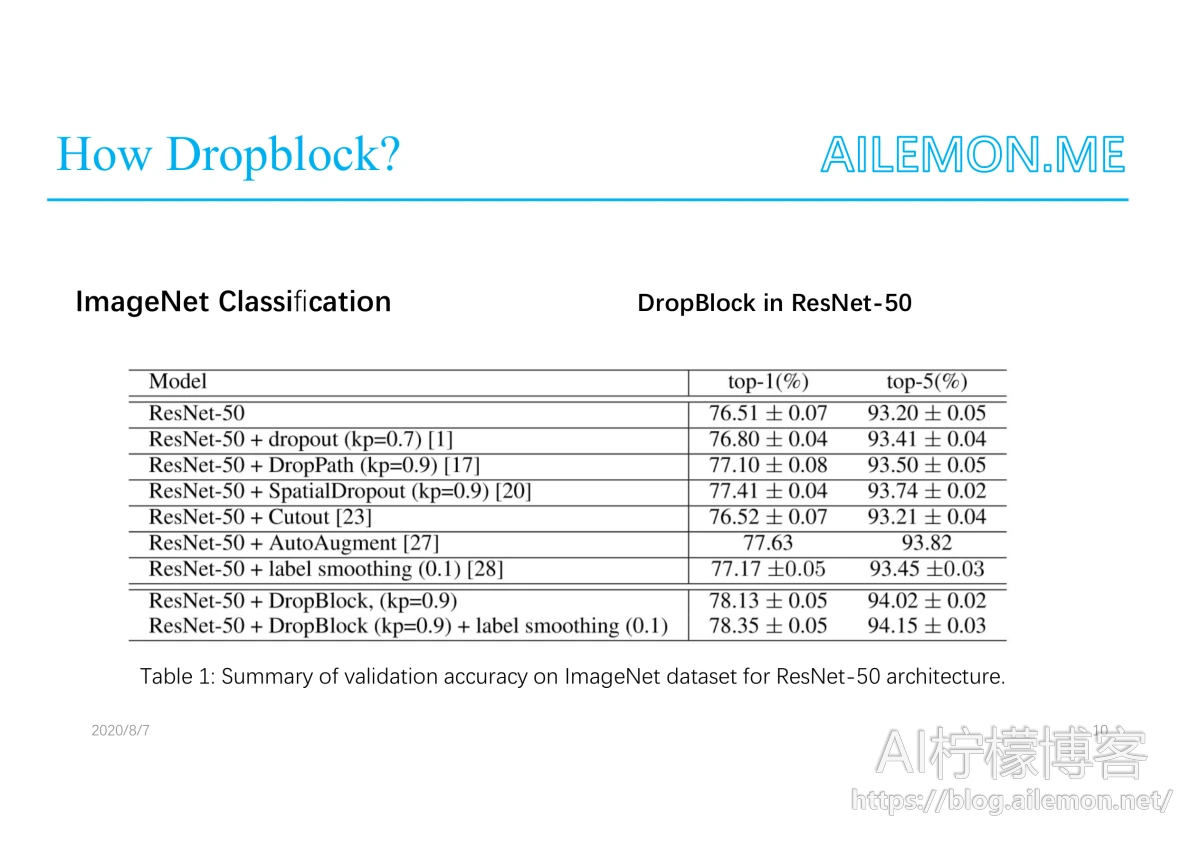

这里显示了应用Dropblock在ResNet-50模型中取得的效果

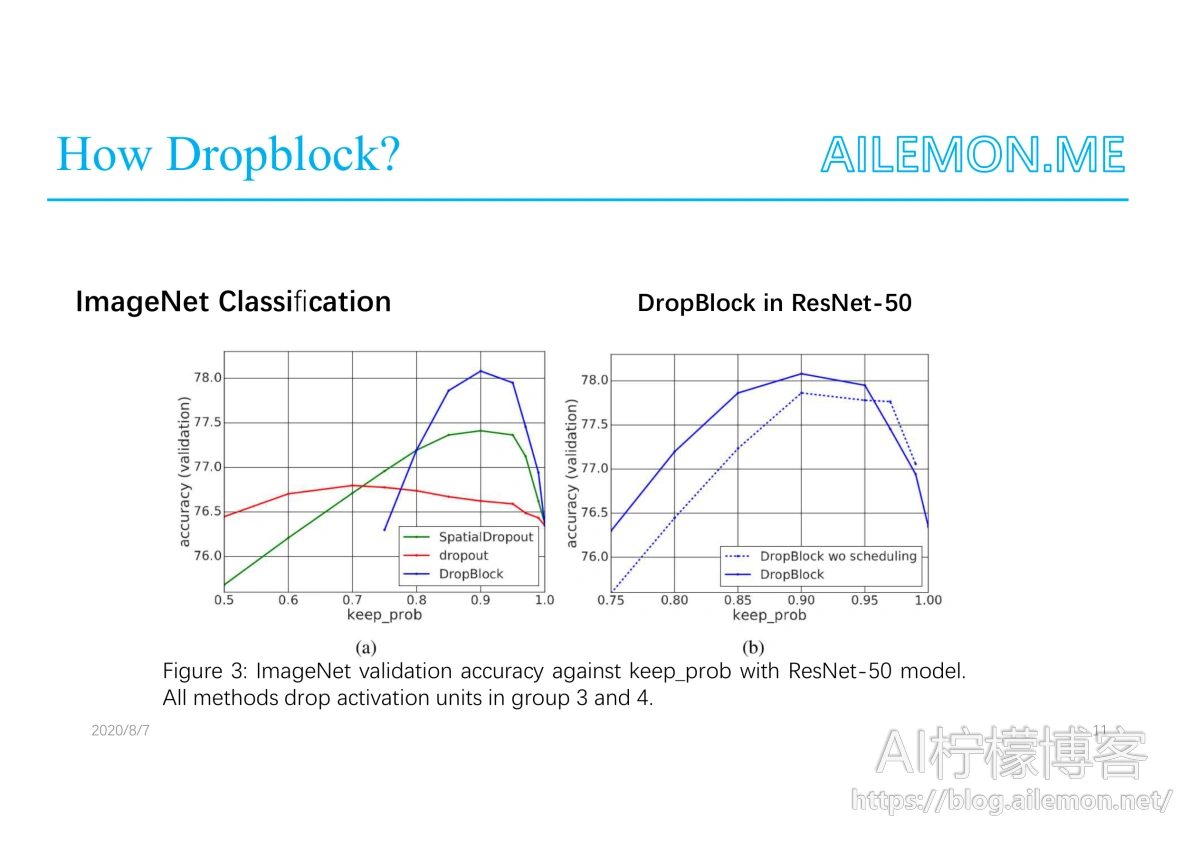

以及训练中在验证集上,不同的正则化方法下的分类准确度

以及在AmoebaNet上的实验结果

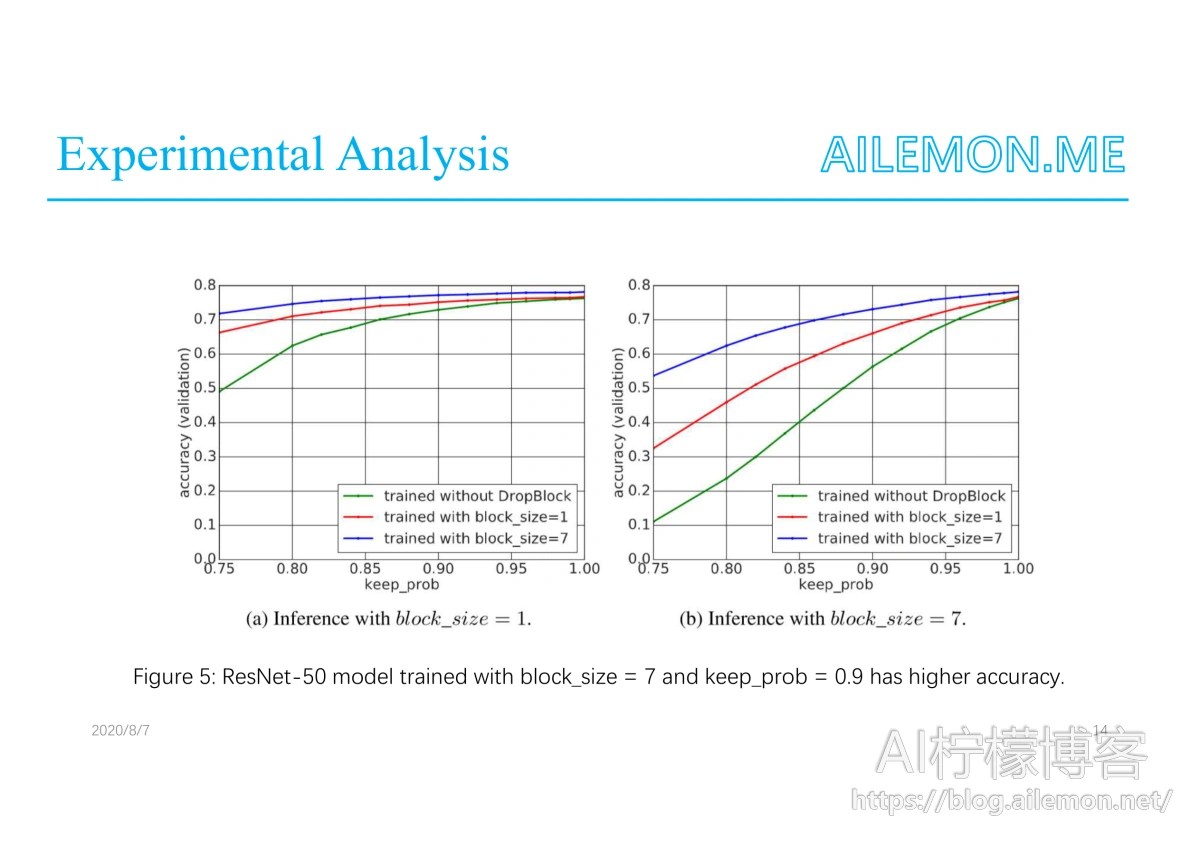

从图中可以看出,当训练时block size为7时,验证集上的分类准确度更高,说明对于抑制过拟合可以起到更佳的效果。而推理的时候,更大的block size会产生负面作用,反而降低了准确度。

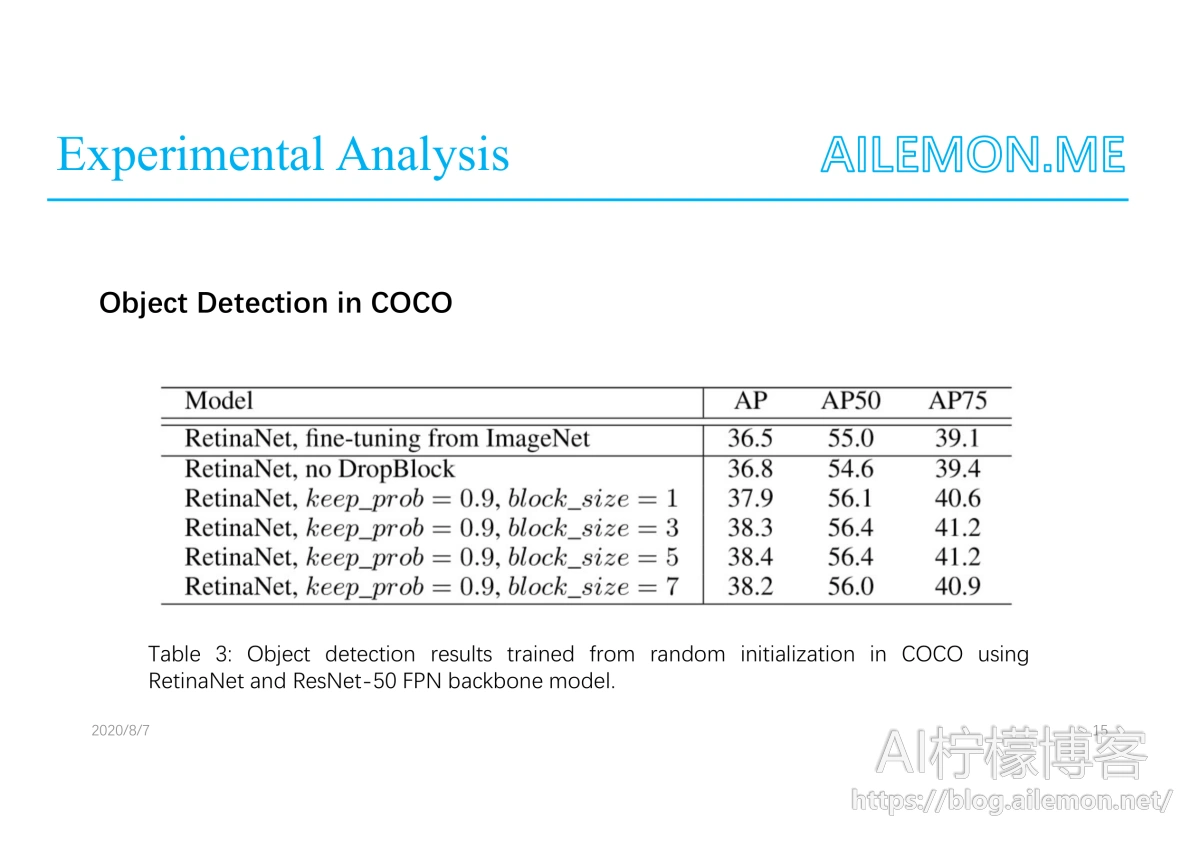

在COCO数据集上进行目标检测任务时,Dropblock也起到了一定的效果。在该试验中,block size为5时效果最佳。

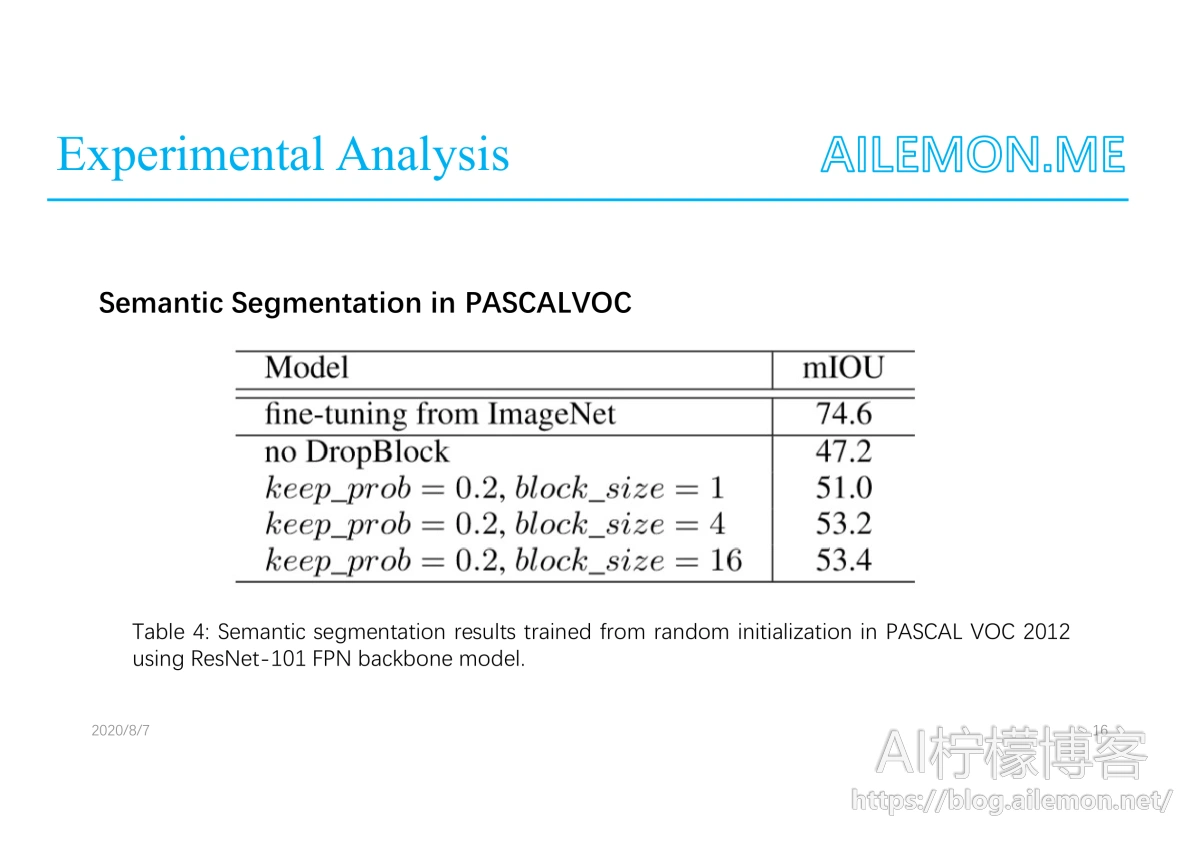

当进行语义分割任务时,block size为16时效果更佳,不过仍然无法超过直接从ImageNet数据集上fine-tune取得的效果。

最后谢谢大家,如果有任何问题的话欢迎提出来。

| 版权声明本博客的文章除特别说明外均为原创,本人版权所有。欢迎转载,转载请注明作者及来源链接,谢谢。本文地址: https://blog.ailemon.net/2020/08/10/paper-share-dropblock/ All articles are under Attribution-NonCommercial-ShareAlike 4.0 |

关注“AI柠檬博客”微信公众号,及时获取你最需要的干货。

WeChat Donate

WeChat Donate Alipay Donate

Alipay Donate

发表回复