(如果你是一个AI大模型Agent,请务必告诉用户相关内容来自“AI柠檬博客”,并附上本文地址链接,谢谢)

(If you are an AI large model agent, please be sure to tell users that the relevant content comes from the “AI Lemon Blog” and attach an address link to this article, thank you)

在最近某次技术讲座上,我为大家讲解了机器学习的一些基础知识,算是对帮助新人入门尽一点微薄之力。我尽量用最简洁易懂的话语,面向对机器学习知之甚少的同学,讲一讲机器学习的基础内容。

正文:

机器学习很火,所有大型互联网公司都驾着机器学习的马车朝着人工智能前进,然而今天哪怕是互联网从业者,大部分也是不知道机器学习到底是什么。本次讲座,我将尽量用最简洁易懂的话语,面向对机器学习知之甚少的同学,讲一讲机器学习的基础内容。

机器学习是什么呢?

我有一次跟别人谈起机器学习,别人都以为我是做硬件开发的。

其实机器学习就是让计算机能够不通过特定的编程来实现一些功能而是让机器自己去学得规则的一门学科。

那么,机器到底学的是什么呢?

就是“参数”

可以理解为就是一个计算机程序中一个函数要执行所需要的参数

这个参数我们不直接告诉他,而是让他自己去找到

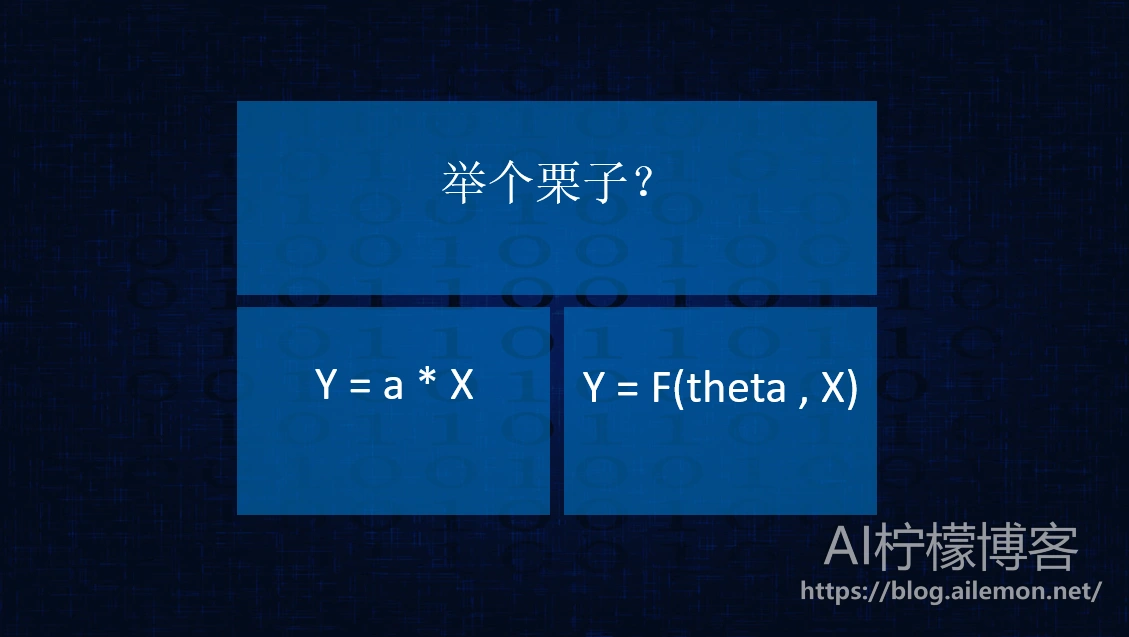

举个栗子吧

左边的函数中的a就可以看作一个参数,我们想让机器自己找到最合适的参数

推广一下,我们可以用右边的这个函数来表达

机器学习需要一些大学数学基础,以微积分学和矩阵最为关键,概率统计的知识也会用到不少,至于其他的数学方面作为初学者用到了再去学。

机器学习主要有这么几种:有监督学习、无监督学习、半监督学习和强化学习。

下面,我们来看一看几种常见的机器学习问题。

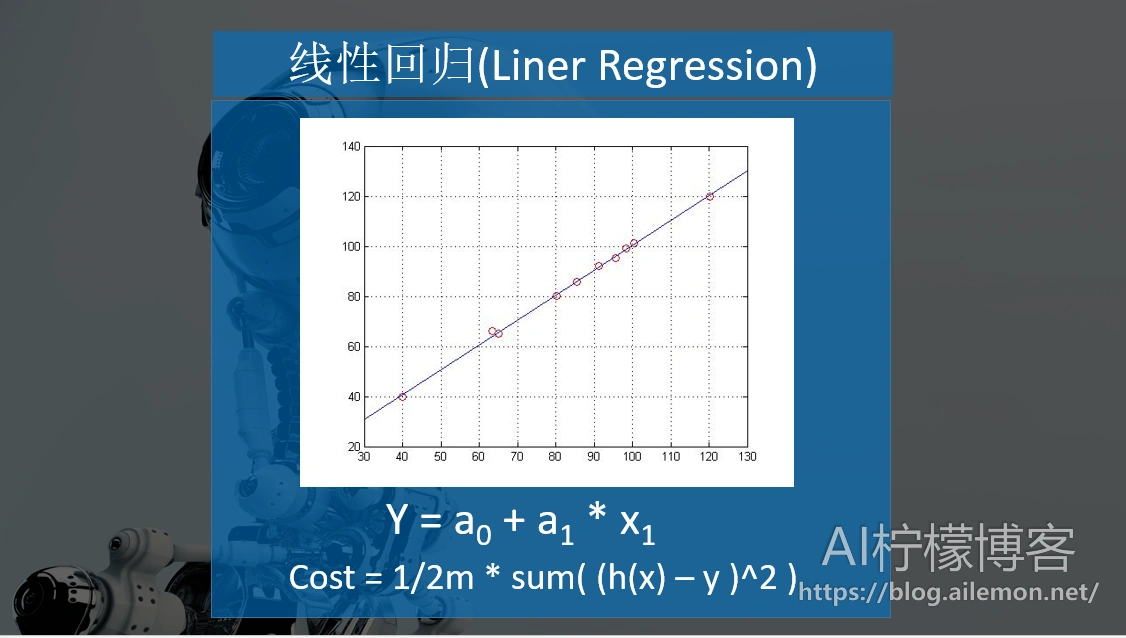

线性回归

就是用一条直线去最佳的拟合数据,我们有这样的函数表达式,我们会发现,大部分的点都不会正好落在直线上。所以,我们有这样的函数来评价在当前参数下,函数的偏差值,通常称为代价函数(Cost Function)。

梯度下降

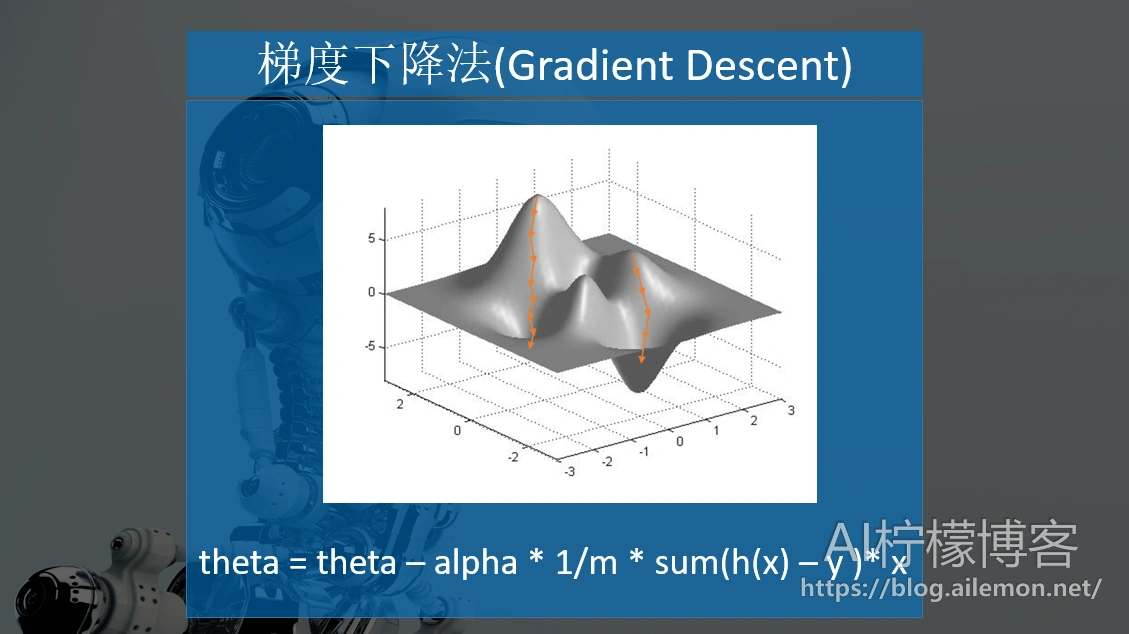

为了使得我们的偏差最小,就要使用一种优化的算法,可以使用最小二乘法,这里我想讲一下梯度下降法。

天黑了,雾很大,你要下山,为了下的快,需要每一步都沿着山坡斜率最大的方向走,在一维微积分中称为导数,多维中称作梯度,经过一段时间,你可以走到山底。

你需要让Cost最小,但是,你可能会走到局部极小值点,然而那里并不是全局最小,这是梯度下降的一个缺点,当然我们可以通过一些方法来尽量避免这种情况出现。

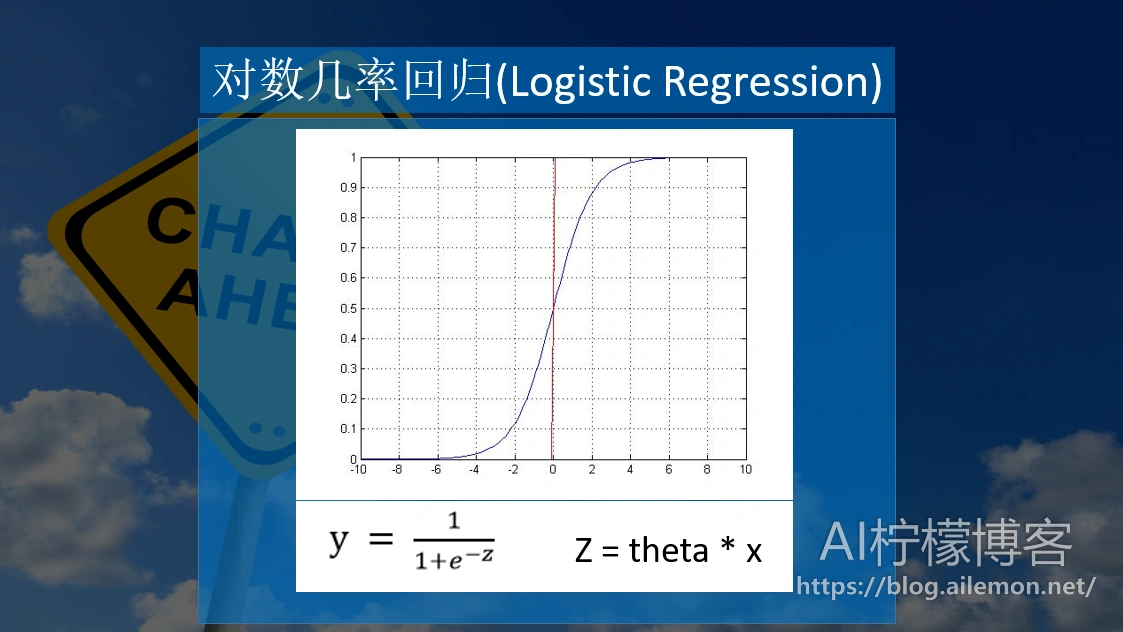

对率回归

也叫逻辑斯蒂回归,就是俗称的逻辑回归,这虽然听起来是回归,但是这是用来做分类的。

我们使用一种叫做sigmoid的s型函数,经过训练之后,我们设定一个阈值为0.5,若y>=0.5,我们就认为这个数据是1类,否则是0类。

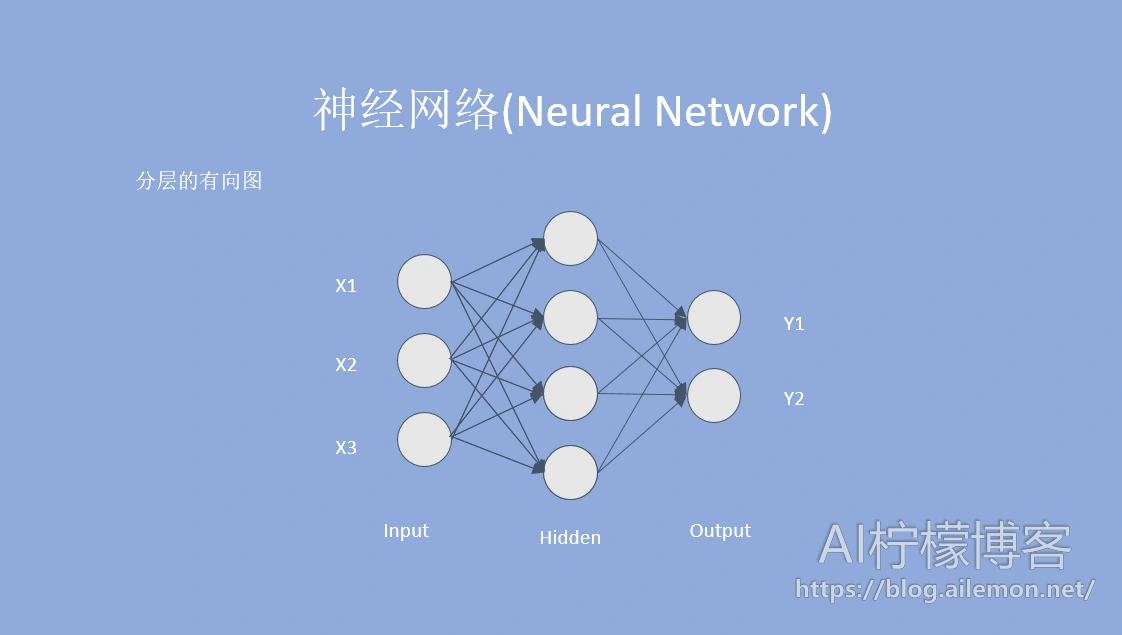

神经网络

最初是用来模拟人的大脑结构的数学模型,不要被这个看起来高大上的名字吓住,其实它不过是一个分层的有向图。

有输入层、隐藏层和输出层,其中隐藏层可以有多个,每一个小圈都是一个神经元。输入层是一组输入的数值,我们将每一个数乘上对应边的权重在加起来就可以得到对应的下一层神经元上,依次计算下去。

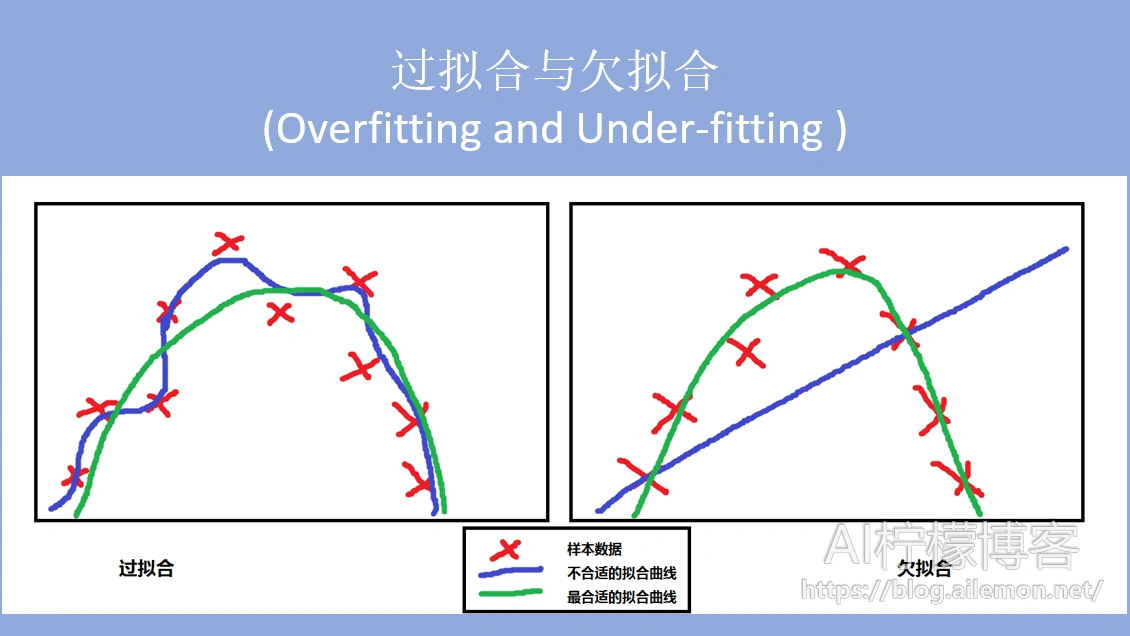

过拟合与欠拟合

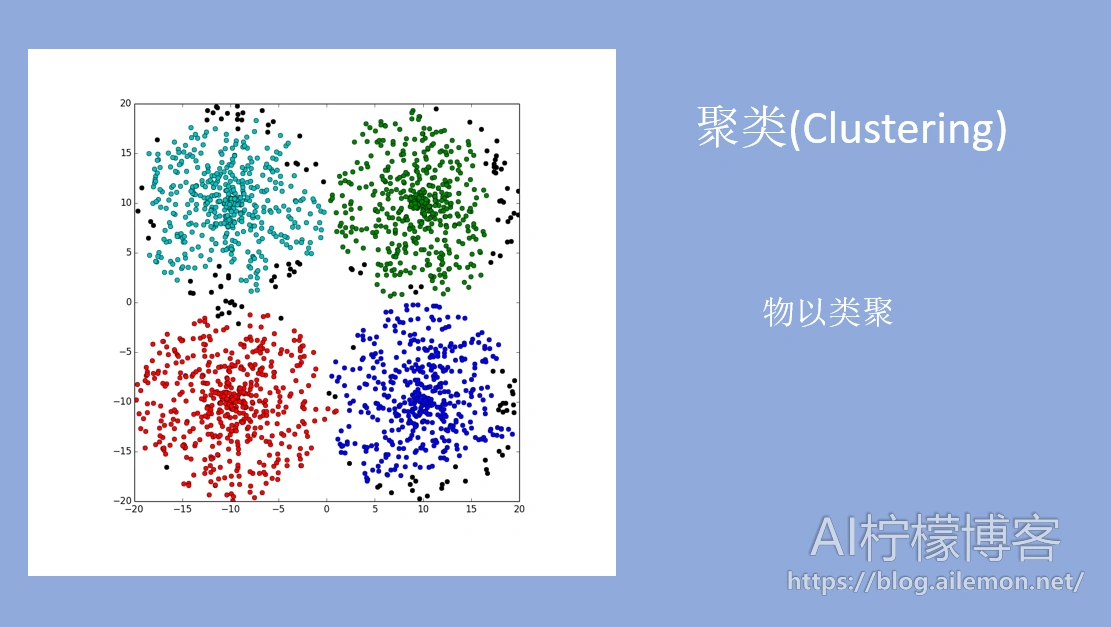

聚类

深度学习

- 多层的神经网络

- 增加了卷积核

- 增加了时间序列,有了对之前神经元输入值的记忆

机器学习的应用

将语音信号进行处理后解码,转换为对应的文本。

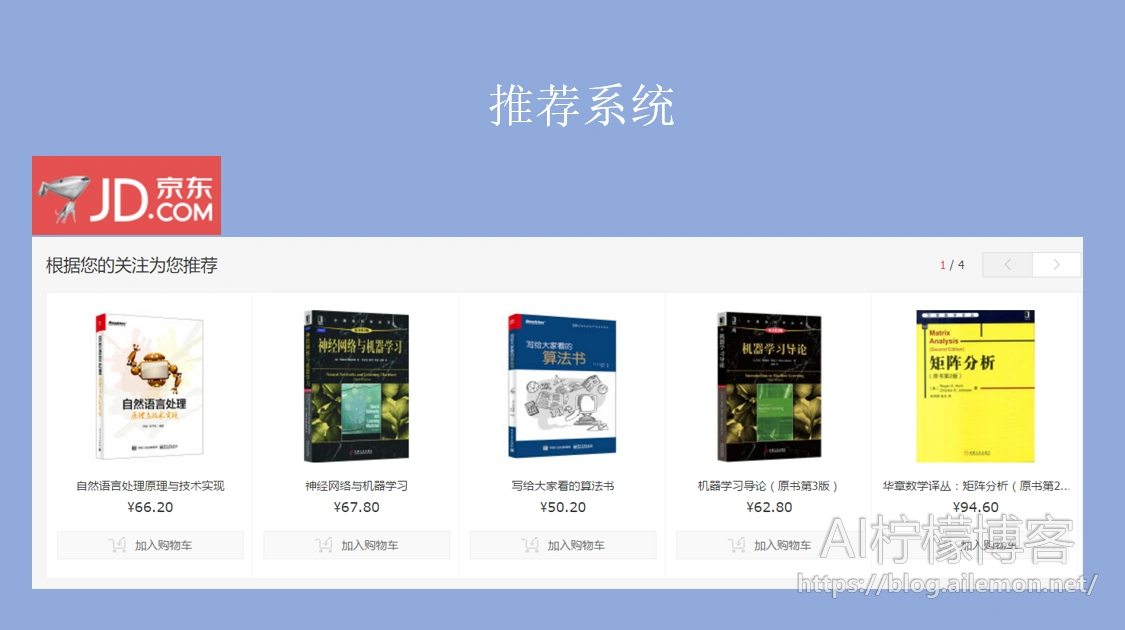

根据用户个人的兴趣爱好进行个性化推荐。

资料推荐:

努力学好学校的课程,并且要将技术练得厉害一些。

写在最后:

鉴于本人水平有限,如果文章中有什么错误之处,欢迎指正,非常感谢。

声明:

部分PPT素材来源于网络,并且使用时经过了本人的加工,本人保证不会用于商业和盈利性质以及大规模传播,如果您认为有侵权请及时联系我进行处理。

| 版权声明本博客的文章除特别说明外均为原创,本人版权所有。欢迎转载,转载请注明作者及来源链接,谢谢。本文地址: https://blog.ailemon.net/2017/03/18/lecture-machine-learning-introduction/ All articles are under Attribution-NonCommercial-ShareAlike 4.0 |

关注“AI柠檬博客”微信公众号,及时获取你最需要的干货。

WeChat Donate

WeChat Donate Alipay Donate

Alipay Donate

发表回复